Mucha gente que ve perder paulatinamente tráfico procedente de buscadores en sus webs lo achaca a penalizaciones por parte de las mismos, olvidándose del peso que puede tener en ese descenso los (cada vez más habituales) cambios de algoritmo.

Antes de avanzar, una rápida explicación sobre ambas. Por un lado están las penalizaciones por las cuales el buscador señala a tu web como spam y le aplica una sanción dentro de sus SERPs. Por otro lado están los cambios de algoritmo que periódicamente realizan los buscadores que te pueden perjudicar o beneficiar.

Aunque hay múltiples casos dentro de cada una, generalmente las penalizaciones provocan fuertes y rápidas caídas de tráfico mientras que las variaciones por cambios de algoritmo no suelen ser tan drásticas.

En ambos casos el escenario es complicado, ya que nadie nos va a avisar cuando los buscadores interpreten que estamos haciendo mal las cosas (bueno, en «honor a la verdad» a veces Google avisa de alguna penalización manual a través de Search Console) y obren en consecuencia. Porque ni en las penalizaciones, que en principio son más fáciles de detectar (no el tipo, si no simplemente que hemos sido penalizados), nadie nos puede asegurar que hundimientos de tráfico puedan ser debidos a ellas ya que también pueden ser provocados por mal uso de meta noindex, robots.txt, fallos de servidor, fallos en la implementación del código del sistema de medición de tráfico web… Incluso dentro de los cambios de algoritmo los hay que afectan en mayor medida y en menor medida.

Entonces nos surge un problema, ¿cómo detectar cuando nos ha «pillado» un cambio de algoritmo? Obviamente nadie quiere perder un 10% de su tráfico, aunque las gráficas visualmente indiquen que la caída es leve.

A continuación explicaré como encontré en una de mis webs una caída de tráfico de buscadores provocada creo (obviamente Google no me lo ha asegurado así que tampoco yo lo puedo afirmar al 100%) por un cambio de algoritmo, cosa siempre complicada debido a lo ya explicado anteriormente (recordar: a.- nadie te va a avisar. 2.- las caídas pueden ser provocadas por causas ajenas al buscador).

Como todo responsable de una web hace, estudio una serie de parámetros mensuales de cada una de mis webs para analizar la evolución de los mismos. Una de ellas son las páginas vistas mensuales, las cuales comparo automáticamente con las del mismo mes del año anterior para evitar la distorsión que puede provocar, al comparar meses consecutivos, la estacionalidad. Por cierto, después de tiempo desechando el dato, ahora también controlo y comparo el número de visitas mensuales, dato más interesante para realizar este pequeño análisis.

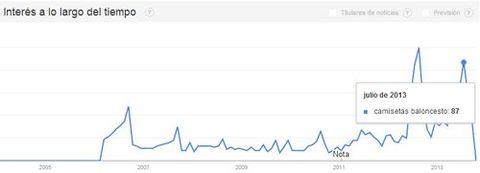

En los datos anteriores se observa claramente como la web

va subiendo como un cohete hasta que en Junio de 2013 el crecimiento se desacelera para comenzar a darse la vuelta a partir de ahí. ¿Qué ha pasado?

En Analytics comprobé que la caída de tráfico tenía como fuente principal los buscadores. Por ello consideré que sería una buena idea comparar los periodos de 2012 y 2013 en los que acaba la subida y comienza la bajada. Filtrando únicamente el tráfico de Google obtengo lo siguiente:

No hay duda. Aunque parece que la caída de tráfico no es evidente mes a mes, por su temática debería empezar a crecer como la espuma y no lo está haciendo. Algo marcha mal, ¿pero el qué?

Mirando la gráfica, en torno al 11 de Junio las tornas parecen cambiar. ¿Hubo cambios en esas fechas en el algoritmo de Google? Al acudir al Google Algorithm Change History de Moz veo que «casualmente» el 11 de Junio hubo movimientos: «Panda Dance» y «Payday Loan Update». ¡De ahí puede surgir mi problema!

Tras lo anterior, estudié la situación y llegué a la conclusión que unos de los cambios, exactamente el «Payday Loan Update», podrían ser los causantes de la situación.

Al no ser una web prioritaria en mi portafolio, no empecé a trabajar en revertir la situación hasta el 29 de Octubre por lo que todavía es pronto para saber si los cambios que he ido haciendo en mi web surgirán efecto. Si lo hacen, contaré en un próximo post lo que he estado haciendo con el objetivo de que G vuelva a «mirar con buenos» ojos a mi web.

Como en SEO es imposible asegurar al 100% ninguna teoría (todo se basa en que nadie conoce el algoritmo) me gustaría conocer tu opinión sobre este post. ¿Estás de acuerdo en que mi web tiene pinta de haberse visto afectada por un cambio de algoritmo? ¿Qué otros parámetros podría analizar para estar más seguro? ¡Gracias por participar!

Comienza oficiosamente el curso 2014/15. Y una de las primeras cosas que he hecho al iniciar esta nueva «temporada» laboral es poner un post it en mi ordenador con el siguiente mensaje: CRO (Conversion Rate Optimization) > SEO (Search Engine Optimization).

Comienza oficiosamente el curso 2014/15. Y una de las primeras cosas que he hecho al iniciar esta nueva «temporada» laboral es poner un post it en mi ordenador con el siguiente mensaje: CRO (Conversion Rate Optimization) > SEO (Search Engine Optimization).